目 次

Liquid Glassで生まれ変わるiPhoneのUI

iOS 26で最も目を引く変化は、何といってもユーザーインターフェースの大刷新です。

Appleは今回、視覚表現を根本から見直し、Liquid Glass(リキッド・グラス)と名付けた新しいデザインコンセプトを導入しました。

これは単なる装飾的な変更ではなく、毎日の操作体験そのものを変えてしまうほどのインパクトを持っています。

透明感と奥行きを演出する新デザインとは?

Liquid Glassの特徴は、その名の通り、ガラスのような滑らかさと透過感をもったUIです。

たとえば、通知センターやコントロールセンターでは、背後のコンテンツが微かに透けて見えることで、画面全体に統一感と奥行きが生まれます。

スライダーやボタンも、ただの平面的なアイコンから、ほんのりと光を含んだ半透明のパネルに変化し、まるで手触りすら感じられそうなリアリティがあります。

Appleはかつて、iOS 7で大幅なフラットデザインへの転換を行いましたが、今回のLiquid Glassは、その反動とも言える触感の回帰です。

洗練と実在感の融合。この方向性は、ビジュアルだけでなく「触れる前に理解できる操作感」へとつながっています。

従来UIとの違いを具体的に比較

従来のiOS(たとえばiOS 17や18)では、機能の表示と操作を区別するようにデザインされていました。

たとえば、ミュージックアプリでは、再生中の楽曲情報とコントロールボタンが画面上で明確に分けられ、異なる階層に配置されていました。

しかし、iOS 26では「機能が視覚的にひとつながり」であるように見せる工夫がなされています。

具体的には、背景のブラー処理を強化することで、ウィジェット・ツールバー・ボタン類が一体化して見え、操作のための視線移動が最小限に抑えられています。

また、各アプリのインターフェースにも変化が見られます。

Safariではタブバーがよりフラットかつ半透明に、設定アプリでは各項目がカード状に再設計され、情報が整理されて見えるだけでなく、視覚的な階層も直感的に把握できます。

このようなUIの再構築によって、iOS 26は「洗練された見た目」以上のもの・・すなわち「操作そのものの心地よさ」を提供しています。

目新しさだけではなく、長時間の使用でも疲れにくいビジュアル設計は、まさにAppleらしい実用美の結晶といえるでしょう。

透明効果の一時弱化と復活

iOS 26のベータ版では、Liquid Glassの透明効果が当初より段階的に調整されてきました。

特にBeta 3では透明感が大幅に弱まり、UIの一体感がやや損なわれたとの声も一部で見られました。

しかし、Beta 4ではこれが大きく修正され、App Storeや写真アプリのツールバーなどにおいて、本来の奥行きと光のある半透明デザインが再び強調されるようになっています。

ロック画面もより一体化したビジュアルに

ロック画面にも新たな進化が加えられています。

被写体の前面に時計表示が入り込むようなレイヤー処理によって、写真とUIが自然に溶け合うデザインが可能となり、まるで壁紙と時計が一体化したかのような臨場感ある表示を実現しています。

これにより、iPhoneの「見た目の完成度」はより一層洗練され、Liquid Glassの思想と一致する視覚体験がロック画面にも広がっています。

Visual Intelligence搭載でスクショが完全活用ツールに

iOS 26では「スクリーンショット」の概念が根本から変わりました。

これまでスクショといえば、「とりあえず記録」「あとで見返す」程度の用途が中心でしたが、iOS 26ではApple Intelligenceの一部としてVisual Intelligence(視覚認識AI)が統合され、画像そのものが使えるデータへと進化しています。

スクショした画像からAIが予定登録や検索を自動提案

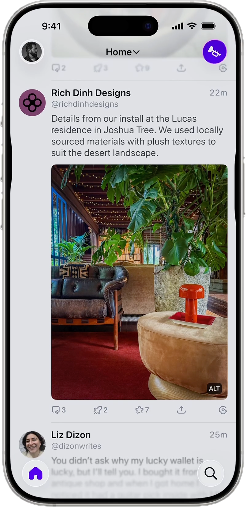

スライドショーを見てください

上の写真だけでは何のことだかわからないですね。

Apple公式サイトのiOS26説明のページに「Apple Intelligence 毎日あれこれ おまかせください」という小見出しのの下に、この写真があってスライドショーになっています。

まず大きな変化は、スクショ画像に含まれる文字や情報をAIが解析し、その内容に応じたアクションを提示してくれる点です。

たとえば、飲食店のメニューを撮影した画像からは、その店名を読み取り、Google検索・マップ表示・営業時間チェックまで一気に可能。

イベントのチラシを撮っただけで、日付・時間・場所が認識され、ワンタップでカレンダー登録できるようにもなっています。

これまでも、

- 写真から文字をコピー

- 電話番号をタップして発信

といった機能はiOSに存在していましたが、それらはユーザーが自ら選択・操作しなければなりませんでした。

Visual Intelligenceでは、画像を開いた瞬間に、

- これを登録しますか?

- この店を調べますか?

といった提案が自動で表示され、意思決定の手間すら減らしてくれます。

これは、もはやスクリーンショットが見るための記録ではなく、行動を起こすための入口になったことを意味します。

HDR撮影とフルスクリーンプレビュー

さらに、スクリーンショット自体の表現力も向上しています。

iOS 26では、従来よりも階調表現の広いHDRスクリーンショットが可能となり、より肉眼に近い鮮明な画像として、表示内容をそのまま記録できるようになっています。

また、スクショをタップした際のプレビュー表示がフルスクリーンに拡張され、周辺情報や背景と重なることなく、集中して内容を確認できます。

これにより、共有・保存・検索といった各ステップでの作業効率が上がり、スクショ→活用までの流れが一貫してスムーズになっています。

この一連の強化は、「情報を整理して覚えておく」というiPhoneユーザーの基本的な行動に直結しています。

iOS26は、単なる視覚記録から、AIが読み取り行動を助けるデジタルの拡張記憶へ、スクリーンショットをそのレベルにまで高めたと言ってよいでしょう。

ライブ翻訳で広がる会話の可能性

言葉の壁は、これまで多くの人にとって「行動のハードル」でした。

特に旅行先や海外との仕事のやりとりでは、

- 英語ができないから

- 相手の言葉が聞き取れないから

という理由で、積極的なコミュニケーションを避けてしまうこともあったでしょう。

しかし、iOS 26が搭載するライブ翻訳機能は、この壁を根本から崩しにかかっています。

Appleはこの新機能を、Siriや通話アプリ、AirPodsの音声体験と緊密に連携させることで、リアルタイムに訳してくれるiPhoneという新たな価値を生み出しました。

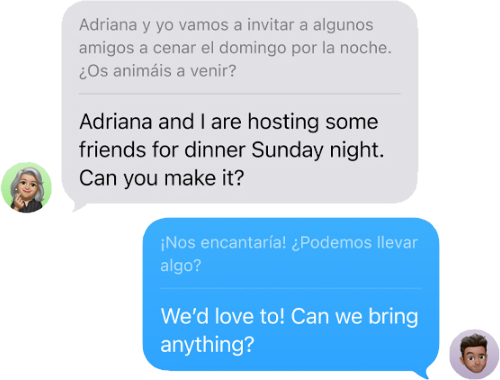

電話・FaceTime・メッセージでリアルタイム翻訳

このリアルタイム翻訳は、単なる翻訳アプリではありません。

実際の通話やFaceTime中に、ユーザーの話す言葉がリアルタイムで翻訳され、相手の画面やイヤホンに伝えられるというインタラクティブな機能です。

通話の字幕表示にも対応し、言語の異なる者同士が自然に会話を進められる環境が整っています。

たとえば、、

日本語しか話せないユーザーが英語圏のレストランに電話をかけるとします。

その際、話した日本語が瞬時に英語へと変換され、相手側には英語で伝わる。

さらに、相手が英語で返してきた内容は日本語でリアルタイムに字幕表示されるため、言語スキルが不十分でも内容を正確に把握できます。

この機能はメッセージアプリにも対応しており、チャットで外国語の相手とやりとりする際、入力した文章が相手の言語に変換され、逆に受信した文章も母国語に翻訳されて表示されます。

翻訳の品質も、従来のApple純正翻訳アプリより大幅に向上しており、日常会話や業務的な内容であれば違和感なく使用できるレベルに達しています。

翻訳精度向上や対応言語の範囲が拡大

現在のところ、対応言語は英語・日本語・中国語・スペイン語・フランス語・ドイツ語など主要な10数言語に限定されていますが、今後はさらに拡大が予定されています。

また、ユーザーの声や口調を識別して訳文のトーンを調整する機能も実験的に搭載されており、単なる直訳ではない「会話として自然な表現」を目指しているのも特徴です。

Appleが従来の翻訳アプリとは別にリアルタイム翻訳を立ち上げた背景には、単に正確に訳すだけでなく、会話そのものの流れを壊さずに進めることに重きを置いているという意図があります。

つまり、これは翻訳というより、コミュニケーションのサポート機能なのです。

「訪問した場所」で日々の行動が可視化可能に

iOS 26では、地図アプリに新しく追加された訪問した場所機能が、ユーザーの移動履歴を自動で記録・視覚化してくれるようになりました。

Googleマップでおなじみのタイムライン機能に似ていますが、Appleはこの機能をよりプライバシーに配慮しながら、iPhoneらしい実用性とデザインで昇華させています。

この新機能は、ユーザーが意識せずに移動した場所をバックグラウンドで記録し、それらを時系列で一覧表示できるようにするもので、日常のちょっとした外出から旅行まで、あとから

- どこに行ったか

- 何時にいたか

が一目で分かる構成になっています。

Googleマップ風履歴ログ機能の利便性とプライバシー

訪問した場所は、Apple純正の「マップ」アプリに統合されており、下部メニューから「あなたの訪問履歴」にアクセスすることで、日付ごとに訪れた場所のリストや、ルートのビジュアル表示が確認できます。

たとえば、ある一日の移動履歴を見ると、朝のカフェ、昼の取引先、夕方のスーパーといった訪問場所が時系列で表示され、そのすべてがマップ上にラインでつながれます。

このような機能は一見すると「行動監視」として懸念されそうですが、Appleは完全にローカル保存(オンデバイス処理)を採用しており、Appleのサーバーには一切送信されない仕組みです。

さらに、ユーザーが望めば履歴の一括削除や、自動削除のスケジュール設定も可能。プライバシーへの配慮を徹底するAppleの姿勢がここにも表れています。

また、訪れた場所に自動でラベルが付き、たとえば

- カフェ

- 駅

- ホテル

などと分類されることで、過去の記録を後から探しやすくなっている点も便利です。

Googleマップではこれが広告データと結びつく設計になっていますが、Appleの訪問した場所はあくまでユーザー本人の記録と回顧に特化した仕組みになっています。

旅行・買い物・エンタメ記録の活用シーン

この訪問した場所の活用範囲は広く、たとえば旅行から帰って「どこを回ったか」を日ごとに確認して、SNSやブログのネタにしたり、同じ旅程を後日誰かに教えたりする際に役立ちます。

これまでは写真の位置情報や記憶に頼っていた部分が、明確な「時系列ログ」として可視化されることで、記録性が格段に向上します。

また、普段の生活でも、

- 最近どこのスーパーに行ってたっけ?

- 出張中に立ち寄った取引先は?

といった、日常の“思い出せそうで思い出せない”情報をすぐに確認できるという意味で、極めて実用的です。

自分の時間の使い方を客観的に振り返るツールとして、あるいはライフログの一部として、訪問した場所はこれまでにない形でiPhoneユーザーの行動を支援します。

Apple Intelligence連携強化

iOS 26において、Apple Intelligenceの進化が、

- 通知の要約

- ビジュアルインテリジェンス

- Image Playground や Genmoji

- カレンダーやリマインダーの提案

など、日常のiPhone操作を多面的に強化しています。

通知サマリーが復活

ベータ4で再導入された「通知を要約」機能では、ニュースやエンタメ系アプリからの通知をApple Intelligenceが一文で要約し、通知内に要約された通知として表示されます。

「元の意味が変わる可能性があります」との注意書きも含まれています。

これは他のメディア記事が根拠

- Summarized by Apple Intelligence:MacRumors

ビジュアルインテリジェンス

iOS 26では、Apple公式で「画面上にあるものにビジュアルインテリジェンスを使う」と明示されており、たとえば、写っている商品についてEtsyで探したり、場所が写っている場合は地図上でその位置を確認することもできます。

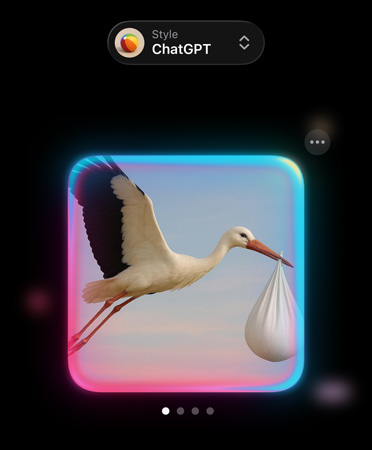

Image Playground/Genmoji

Genmojiでは、従来のカスタマイズに加えて複数の絵文字を合成して新しい表現を作る機能が新たに導入されました。

たとえば「バスケットボール」と「ゴミ箱」を組み合わせたユニークな絵文字を自分で生成することができたりします。

また、表情・髪型・アクセサリなどの細かな属性設定も可能になり、より自由度の高い絵文字表現が可能になっています。

Image Playgroundとの統合も進み、同一画面上でGenmojiを生成・編集できるようになりました。

これにより、画像生成と絵文字作成のワークフローが一体化され、Appleの生成AIを使ったビジュアル制作がよりスムーズになります。

どちらの機能も、メッセージアプリやメモ、ショートカットなどから直接呼び出して利用でき、日常の表現力を大きく広げるツールとして進化しています。

カレンダー/リマインダーの提案

Apple Intelligenceは、ユーザーがiPhone上で現在表示している、

- 画像

- スクリーンショット

- Webページ

などの画面コンテンツを解析し、その中に含まれる日時や場所の情報を自動で検出します。

そして、たとえば「○月○日14時に渋谷で会おう」などの情報が写っている場合、システムが、

- カレンダーに追加しますか?

- リマインダーを作成しますか?

と提案してくれます。

このようにApple Intelligenceは、ユーザーが明示的に入力していない情報も、表示中の画面から読み取って予定化を支援することで、日々のスケジュール管理をよりスムーズにしてくれます。

この機能は「ビジュアルインテリジェンス」と呼ばれ、AppleがiOS 26で重点的に強化した支援機能の一つです。

プライバシー重視の設計

Apple Intelligenceの処理は多くが端末内で完結し、クラウドへの個人データ送信は最小限です。

また、ユーザー主体でChatGPT連携のオン/オフを選べます。

細やかな操作改善/便利機能まとめ

iOS 26では、目立つAI機能やビジュアル刷新に注目が集まっていますが、それと並行して、日常的な操作性を大幅に改善する細やかな新機能・改善点も多数追加されています。

こうした変化は、派手さはないものの、毎日の使い勝手に直結するため、ユーザーの満足度を底上げする縁の下の力持ちのような存在です。

ここでは、見落とされがちだが実際には非常に便利な改良点をいくつか取り上げて解説します。

カレンダー自動登録やカスタムスヌーズなどの地味に効く改善

iOS 26では、メールやメッセージの文中に含まれる日付・時刻・場所の情報から、カレンダーへの自動登録がこれまで以上にスムーズになりました。

これまでは日時をタップ→カレンダーへ移動→登録という手順が必要でしたが、Apple Intelligenceの処理によって、「イベントを登録しますか?」という提案が直接表示され、ワンタップで登録が完了します。

また、目覚まし時計やリマインダーにおいても「スヌーズ時間を自由に設定できる」ようになったのは注目点です。

従来は一律9分で固定されていましたが、今後はユーザーが好みの間隔(たとえば5分、12分など)に調整でき、睡眠リズムや仕事の都合に合わせた運用が可能になります。

さらに、通話中の通話保持機能も改善されており、特にサポートセンターなどで保留状態になった際、「相手が戻ったら自動で通知してくれる」仕組みが搭載されました。

これにより、保留のあいだ他の作業をしていても聞き逃すことがなく、作業効率が向上します。

Accessibility強化やeSIM Android転送など地味に見えて実用的な変更点

iOS 26では、アクセシビリティ(利用支援)関連の強化も進んでいます。

たとえば、視覚障害を持つユーザーのために、画面内の要素をより明確に読み上げる新しいナビゲーション構造が導入されており、VoiceOverユーザーにとっては大きな改善です。

また、海外ユーザーやAndroidからの移行を検討する人にとって朗報なのが、eSIMのAndroid端末からiPhoneへの転送が簡略化されたことです。

これまでは、キャリアの手続きやQRコードの再取得が必要だったのが、iOS 26ではBluetooth経由で直接eSIMプロファイルを転送できるようになり、乗り換えのハードルが下がりました。

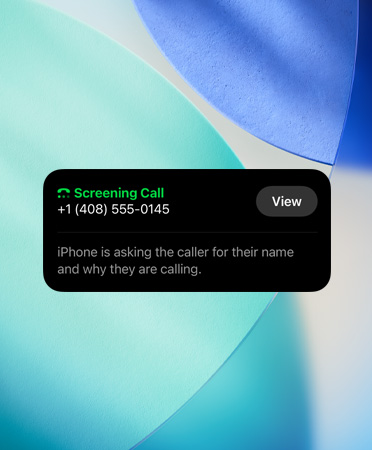

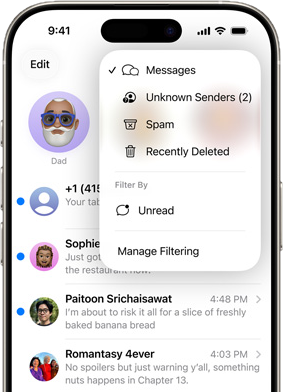

不明な送信者のスクリーニング機能が強化

iOS 26では、メッセージアプリにおけるスクリーニング機能が進化しました。

不明な番号からのメッセージを自動で振り分けるだけでなく、今後受信するかどうかの判断や、表示の制御もユーザー側で柔軟に設定可能に。

これにより、スパム対策がより高度になり、メッセージアプリの利便性と安心感が向上しています。

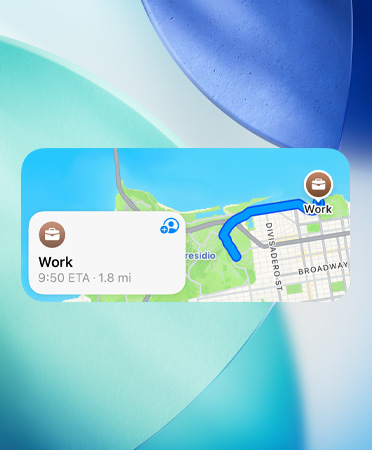

マップウィジェットで経路を即確認

マップアプリに関連しては、ウィジェット表示の視認性が向上し、リアルタイムの経路情報や到着予想時刻(ETA)などを大きく見やすく表示できるようになりました。

これにより、ロック画面やホーム画面上からでも、現在地や目的地までの状況を即座に把握できるため、ナビゲーションアプリとしての実用性がさらに強化されています。

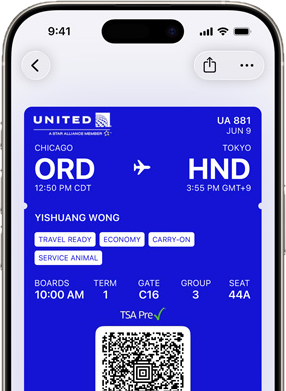

ウォレットで搭乗券も見やすく整理

ウォレットアプリでは、搭乗券や支払いカードの表示がより立体的かつ情報整理されたUIに刷新されました。

スクロールや表示切替も滑らかになり、複数の情報(座席・出発ゲート・搭乗時刻など)をすばやく確認できるようになっています。

iOS 26では日常生活のリアルな利用シーンにおいても、ストレスの少ない操作体験を提供する工夫が徹底されています。

隠れ機能-知って得する小ネタ集

新絵文字8種が追加(Unicode 17対応)

iOS 26では、Unicode 17への準拠により、8種類の新しい絵文字が追加されました。

以下のとおりです。

- Trombone:トロンボーン

- Treasure Chest:宝箱

- Distorted Face:ゆがんだ顔

- Hairy Creature(Bigfoot):毛むくじゃらの生き物(ビッグフット)

- Fight Cloud:ケンカの煙(??どう訳せばいいのか??)

- Apple Core:リンゴの芯

- Orca:シャチ

- Ballet Dancers:バレエダンサーたち

SNSやチャットでの表現の幅が広がる点で、若年層を中心に歓迎されるアップデートといえるでしょう。

Genmoji:自分だけのオリジナル絵文字を生成

iOS 26では、Apple Intelligenceを活用した新機能「Genmoji(ジェンモジ)」が追加されました。

ユーザーが入力したテキストに基づき、ユニークでパーソナライズされた絵文字を即座に生成し、iMessageなどで共有可能です。

たとえば、

- 笑っているサボテン

- 宇宙服を着た猫

といった自由な組み合わせを言語から生成でき、従来のミー文字とは異なる、より即興的かつ創造的な表現が可能になります。

さらに、生成された絵文字は、

- 肌の色

- 髪型

- 表情

- アクセサリー

などをタップ操作で細かくカスタマイズすることも可能で、自分の感情やスタイルを反映した唯一無二の表現が可能です。

これは従来のミー文字とは異なり、即興的かつ多様性に富んだ表現が魅力であり、日々のやりとりをよりパーソナルで楽しいものにしてくれます。

スクリーンショット後の即アクション強化

iOS 26では、「Visual Look Up(調べる)」機能が強化され、スクリーンショットを撮影した直後に、

- 画像内の情報の検索

- 日時やイベントの検出→カレンダー登録提案

- 電話番号の認識→発信ボタンの表示

など、文脈に応じた即時アクションが表示されるようになりました。

これにより、スクリーンショットを単なる記録から即活用ツールへと変える動きが進んでいます。

アプリに追加された新しいUIアニメーション

iOS 26では、Apple MusicやNewsなどの純正アプリにおいて、タブバーがコンテンツの上に浮かぶように表示される新UIが導入されました。

スクロールに応じて自動で隠れたり現れたりする動きが加わっており、視認性と操作性の両立が図られています。

この動的インターフェースは、従来の静的なUIとは一線を画し、操作の直感性を高める工夫の一つです。

着信スクリーニングが不明な電話に自動対応

iOS 26では、不明な電話番号からの着信に対し、自動的に応答する「着信スクリーニング」機能が搭載されました。

発信者が名前と用件を話すと、それをiPhoneが記録し、要件の内容が分かった段階でユーザーに通知されます。

電話に出るかどうかを、その情報をもとに判断できるため、迷惑電話への対応が格段に効率化されます。

保留アシストで待機中の対応を逃さない

カスタマーサポートなどで長時間の保留になるケースでも、iPhoneが自動で「オペレーターが対応を始めた」ことを検出し、ユーザーに通知する「保留アシスト」が追加されました。

これにより、他の作業をしていても対応のタイミングを逃さず、待機ストレスを軽減できます。

パブリックベータ開始&正式リリース予定解説

ここまでiOS 26の主な新機能を見てきましたが、

- いつから使えるのか?

- 自分のiPhoneは対応機種なのか?

という実務的な疑問を持つ読者も多いはずです。本章では、リリーススケジュールと対応機種、ベータ版導入方法について説明します

パブリックベータは「まもなく開始予定」

Apple公式βプログラムのサイトでは、iOS 26(およびiPadOS 26/macOS Tahoe 26など)について、「まもなく提供開始」と案内されています。

現時点(今は7月24日10:23AM)では「近日中」の段階であり、正式な配信はまだ始まっていません。

正式リリースは9月中旬が見込み

例年のスケジュール通り、iOS 26の正式版は9月中旬(iPhoneの新モデル発表時期)に公開されると予想されます

ベータ版の導入方法

Apple Beta Software Programに参加していれば、準備が整い次第、

設定>一般>ソフトウェア・アップデート>ベータアップデート

で、iOS 26パブリックベータが選択可能になります。デバイスの種類に関係なく利用できる点が特徴です

リスクを取れぬ方は導入しない方が良い

ベータ版はあくまで開発途中のソフトウェアであり、不具合や予期せぬ動作が発生する可能性があります。

OSの仕組みに詳しくない方や、不具合発生時に自力で対応できない方は、導入を控えることを強くおすすめします。

特に、日常的に使用しているメイン端末での利用は避け、予備端末などでのテストを検討してください。

対応機種と利用上の注意

対応機種は以下のとおりです。

但し、対応機種であっても、すべての機能が使えるわけではありません。

Genmoji、書き起こし要約、Visual Intelligenceやショートカットとの連携機能などの Apple Intelligence機能は、

- A17 Proチップ搭載のiPhone 15 Pro/15 Pro Max

- すべてのiPhone 16シリーズ

でのみ利用可能です。その他のiPhone(例:iPhone 15無印・15 Plusなど)は対象外です

まとめ

見た目の刷新:Liquid Glassが操作の直感性を高める

iOS 26では、インターフェース全体がLiquid Glassによって再構築されました。

従来のように要素ごとに分断されたデザインではなく、透明感や奥行き、ブラー処理を活用した一体感あるUIによって、視覚的な快適さと操作性が融合しています。

通知やロック画面も含め、情報の階層を意識せずに使えるレイアウトは、見た目の変化だけでなく、操作そのものの迷いを減らす実用的な進化です。

AIによる支援:Apple Intelligenceが気の利いたiPhone体験を提供

iOS 26は、Apple Intelligenceの導入によって、Siriや各種アプリの使い方が大きく変わりました。

- メールの要約やリライト提案

- カレンダーやリマインダーの自動生成

- 通知サマリーの再実装

- Visual Intelligence によるスクリーンショットの文脈理解

これらの機能は、単なるアシスタントではなく、ユーザーの行動を予測し先回りして助けてくれる存在へと進化しています。

しかも処理はほとんどがオンデバイスで行われ、Appleらしいプライバシー設計が守られています。

地味に効く改善:実用性を底上げする細部のアップデート

iOS 26には、派手ではないが明確に使いやすさを高める改善が多数存在します。

- 着信スクリーニング機能(不明な番号への自動応答)

- 不明な送信者のふるい分けと通知整理

- スヌーズ時間のカスタム設定

- eSIMのBluetooth転送対応

- 地図ウィジェットによる経路確認の迅速化

- ウォレット内チケットの視認性向上

- スクリーンショットから即アクション

- 訪問した場所の記録と視覚化

- Unicode 17対応の新絵文字

- Genmojiで自作できる個性的な絵文字

これらの改善は、日常のワンタップを減らし、考える手間を減らすという観点で、継続的に使い込むほどその価値がわかる設計になっています。

iOS 26はこんな人におすすめ

- 日々の予定やタスク管理を効率化したい人

- AIによるサポートに価値を感じる人

- iPhoneの見た目と操作性を両立させたい人

- 外国語を含む音声通話やメッセージを多用する人

- スクリーンショットを情報共有に活用している人

- 自作絵文字や新しい表現手段を楽しみたい人

- ロック画面や通知などを視覚的に整理したい人

一方で、

- 新しいデザインに馴染みたくない

- AIによる介入を最小限にしたい

と考える方には、様子見やアップデートの見送りも一つの選択肢です。

最後に:iOS 26はiPhoneの「第三の転換点」かもしれない

過去、iOS 7でのフラットデザイン化、iOS 14でのウィジェット導入に続き、iOS 26は

- AIによる知的支援

- UIの視覚刷新

という2つの軸で、iPhoneの体験を根底から再定義しました。

iPhoneは今、単なる操作端末から、行動を読み取り、予測し、補助してくれるパートナーへと変化を遂げようとしています。

アップデートすべきか迷っている方も、一度ご自身の使い方と照らし合わせて、「今、本当に必要な進化かどうか」を考えてみてください。

iOS 26は、見た目や機能だけでなく、iPhoneがあなたの生活にどう寄り添えるかを再設計した、大きな節目です。

新しいiOSがどのように進化し、日々の使い勝手にどんな変化をもたらすのか・・それを事前に把握しておきたい方のための実用ガイドです。